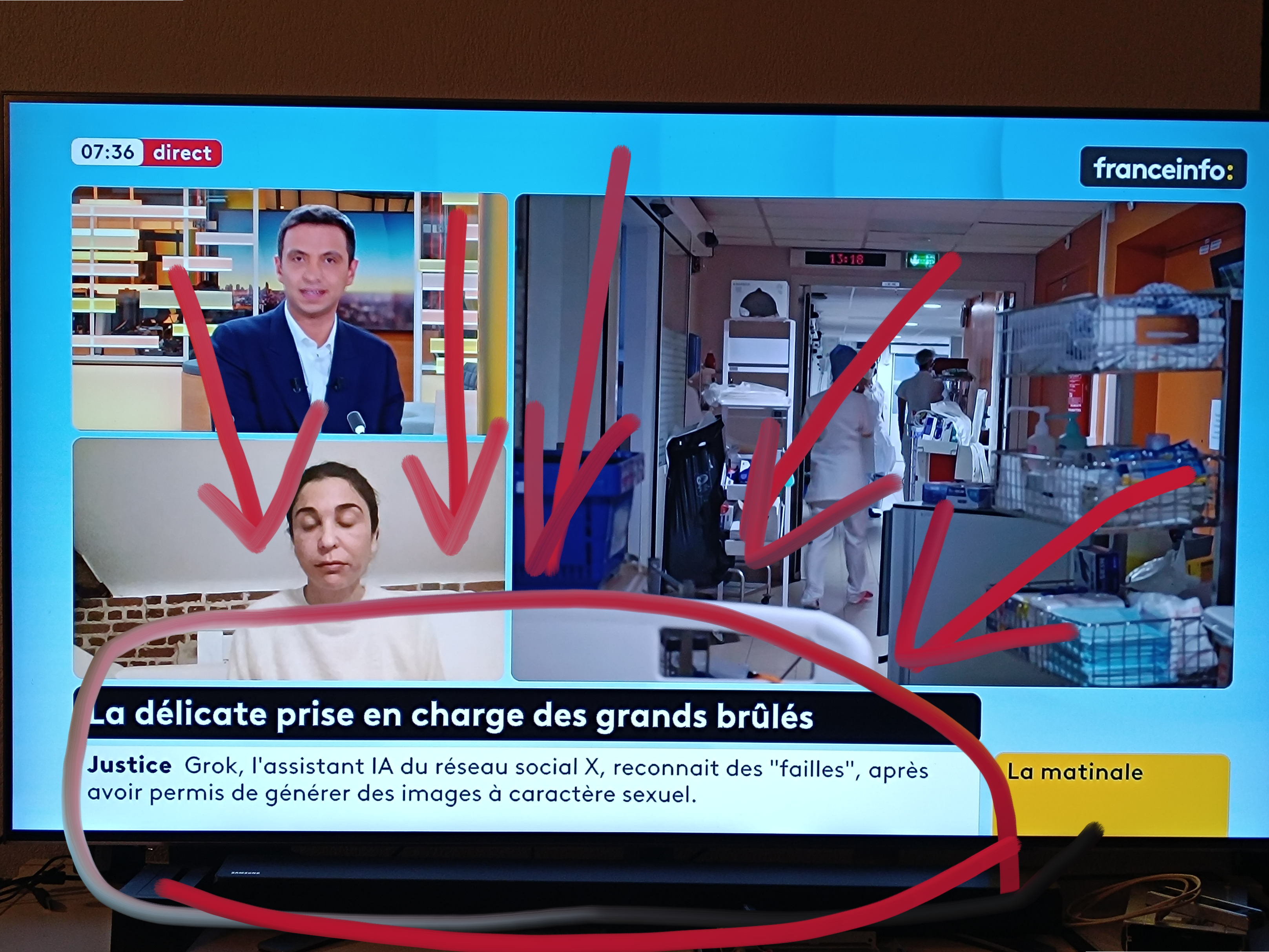

Vu sur France Info,

Ce bandeau informatif assez malaisant:

«Justice Grok, l’assistant IA du réseau social X, reconnaît des « failles », après avoir permis de générer des images à caractère sexuel.»

Dire «Grok reconnaît des failles» est une anthropomorphisation abusive.

Un logiciel n’a ni intention, ni conscience, ni responsabilité morale.

Il exécute des choix humain: grâce à une architecture, des données, des filtres et des arbitrages fixés par des développeurs.

Attribuer une “faute” à l’IA déplace subtilement la responsabilité:

Ce ne sont pas les modèles qui décident de ce qu’ils autorisent, mais les équipes qui les conçoivent, les entraînent et les déploient.

Ce glissement de langage n’est pas anodin:

il transforme un problème de gouvernance humaine en incident technique abstrait, diluant ainsi la responsabilité juridique et éthique des concepteurs.

Accepter ce cadrage, c’est ouvrir la porte à « ’IA a discriminé», «K’IA a diffamé», «L’IA a radicalisé» etc. autrement dit, des dommages réels sans responsables clairement identifiés.

L’IA n’est pas un sujet moral mais un outil.

La présenter comme fautive protège les décideurs humains.

Bref, au secours.